丁苯肽的药物功效

病情分析:据文献记载:丁苯肽软胶囊的活性成分为dl-3-正丁基苯酞,为人工合成的消旋体,其左旋体存在于芹菜籽中。

有哪些推理解密的游戏推荐

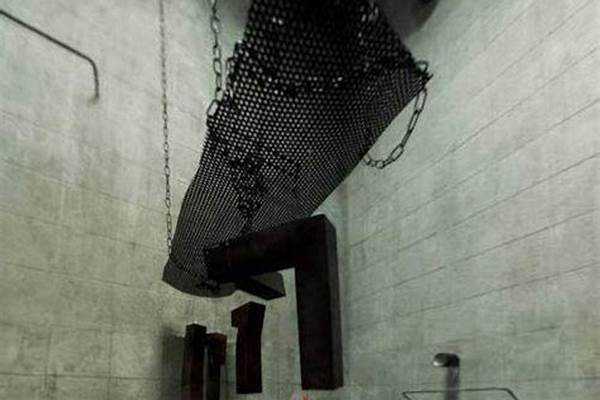

《第五人格》很好玩,游戏画面精美,地图好看地形又好!人物有很多医生、祭司、调香师、盲女、园丁、先知、这都是我平常玩的!

深度强化学习领域近期有什么新进展

深度强化学习是近年来人工智能领域内最受关注的研究方向之一,并已在游戏和机器人控制等领域取得了很多耀眼的成果。DeepMind 的工程师 Joyce Xu 近日发表了一篇博客文章,介绍了深度强化学习领域的一些近期进展,其中涉及到分层式强化学习、记忆、注意机制、世界模型和想象等方向。

我觉得,深度强化学习最让人喜欢的一点是它确实实在难以有效,这一点不同于监督学习。用神经网络来解决一个计算机视觉问题可能能达到 80% 的效果;而如果用神经网络来处理强化学习问题,你可能就只能眼睁睁地看着它失败——而且你每次尝试时遭受的失败都各不相同。

强化学习领域内的很多最大的挑战都围绕着两大问题:如何有效地与环境交互(比如探索与利用、样本效率),以及如何有效地从经历中学习(比如长期信用分配、稀疏奖励信号)。在这篇文章中,我希望探讨深度强化学习领域内试图解决这些挑战的几个近期研究方向,并且还会将其与人类认知进行优雅简洁的对比。具体而言,我将谈到:

分层式强化学习

记忆和预测建模

将无模型方法与基于模型的方法组合到一起

本文首先将简要介绍两个代表性的深度强化学习算法——DQN 和 A3C,以为后文提供能够作为参考的直观知识,然后我们会深入探讨几篇近期的论文和研究突破。

DQN 和 A3C/A2C

声明:我假设读者已经对强化学习有一定的基本了解了(因此这里不会提供有关这些算法的深度教程),但就算你对强化学习算法的工作并不完全了解,你应该也能阅读后文的内容。

DeepMind 的 DQN(深度 Q 网络)是将深度学习应用于强化学习的最早期突破性成功之一。其中使用了一个神经网络来学习用于经典 Atari 游戏的 Q 函数,比如《乒乓球》和《打砖块》,从而让模型可以直接根据原始像素输入得出应该采取的动作。

从算法上看,DQN 直接源自经典的 Q 学习技术。在 Q 学习中,一个状态-动作对的 Q 值(即 quality 值)是通过基于经历的迭代式更新来估计的。从本质上讲,对于某个状态下我们可采取的每个动作,我们都可以使用收到的即时奖励和对新状态的价值估计来更新原来的状态-动作对的价值估计:

DQN 的训练是最小化时间差分误差(TD-error)的 MSE(均方误差),如上所示。DQN 使用了两个关键策略来使 Q 学习适用于深度神经网络,而且这两个策略也在后续的深度强化学习研究中得到了成功的应用。这两个策略为:

经历重放(experience replay),其中每个状态/动作转换元组 (s, a, r, s』) 都存储在一个记忆「重放」缓存冲,并会被随机采样以用于训练网络,从而可实现对训练数据的重复使用和去除连续轨迹样本中的相关性。

使用一个单独的目标网络(即上式中的 Q_hat 部分)来实现训练的稳定,所以 TD 误差不是根据源自训练网络的不断变化的目标计算的,而是根据由一个基本固定的网络所生成的稳定目标计算的。

在那之后,DeepMind 的 A3C(Asynchronous Advantage Actor Critic)和 OpenAI 的同步式变体 A2C 也非常成功地将深度学习方法推广到了 actor-critic 方法上。

actor-critic 方法将策略梯度方法与一种学习后的价值函数结合到了一起。对于 DQN 方法,我们仅有学习后的价值函数(即 Q 函数),而我们遵循的「策略」只是简单地在每个步骤取能最大化 Q 值的动作。使用 A3C 和使用其它 actor-critic 方法一样,我们会学习两个不同的函数:策略(即 actor)和价值(即 critic)。策略函数是基于采取该动作的当前估计优势(advantage)来调整动作概率,而价值函数则是基于经历和后续策略收集到的奖励来更新该优势:

从上面的更新可以看出,价值网络会学习一个基线状态值 V(s_i;θ_v),我们可以将其与我们的当前奖励估计 R 进行比较,从而得到「优势」;策略网络则会通过经典的 REINFORCE 算法根据该优势调整动作的对数概率。

A3C 真正的贡献在于其并行化和异步化的架构:多个 actor 学习器被分派到不同的环境实例中;它们全都会与环境进行交互并收集经历,然后异步地将它们的梯度更新推送到一个中心的「目标网络」(一个借用自 DQN 的思路)。之后,OpenAI 的 A2C 研究表明异步实际上对性能没有贡献,而且事实上还会降低样本效率。对这些架构的详细解释已经超出了本文的覆盖范围,但如果你和我一样对分布式智能体感兴趣,那一定要看看 DeepMind 的 IMPALA,这是一种非常有用的设计范式,可用于实现对学习的扩展:。

DQN 和 A3C/A2C 都是非常强大的基线智能体,但是在面对更加复杂的任务、严重的部分可观察性和/或动作与相关奖励信号之间存在较长延迟时,这些智能体往往难以为继。因此,强化学习研究中有一整个子领域在致力于解决这些问题。接下来我们看看其中一些优秀的研究。

分层式强化学习(HRL)

分层式强化学习是一类从多个策略层学习的强化学习方法,其中每一层都负责控制不同层面的时间和行为抽象。最低层面的策略负责输出环境动作,让更高层面的策略可以操作更抽象的目标和更长的时间尺度。

为什么这种方法很吸引人?首先也是最重要的一点是在认知方面,有很多研究都认为人类和动物行为都基于分层式结构。这在日常生活中有直观的体现:当我决定做一顿饭时(实际上我基本从不做饭,但为了合理论述,就假设我是一个负责的人类吧),我会将这一任务分成多个更简单的子任务(切蔬菜、煮面条等),但绝不会忽视我要做饭的总体目标;我甚至还能切换不同的子任务来完成同样的目标,比如不煮面条而是蒸饭。这说明真实世界任务中存在固有的层次结构和组合性质,因此可将简单的基础动作串接、重复或组合起来以完成复杂的工作。近些年的一些研究甚至发现 HRL 组件与前额叶皮质中的特定神经结构之间存在直接的相似性。

从技术方面看,HRL 尤其引人注目,因为它能帮助解决我们前文提到的第二个问题的两大挑战:如何有效地从经历中学习(比如长期信用分配、稀疏奖励信号)。在 HRL 中,因为低层策略是基于高层策略分配的任务从内在奖励中学习的,所以尽管奖励稀疏,基础任务仍可得以学习。此外,高层策略发展起来的时间抽象让我们的模型可以根据时间上延展的经历来处理信用分配问题。

所以 HRL 的工作是怎样的?目前有一些各不相同的方法都能实现 HRL。Google Brain 近期的一篇论文采用了一种尤其清晰和简单的方法,并为数据高效型训练引入了一些很好的离策略修正方法。他们的模型名为 HIRO:。

μ_hi 是高层面的策略,其为低层面的策略输出需要实现的「目标状态」。μ_lo 是低层面的策略,输出环境动作以试图达成其目标状态观察。

其设计思路是有两个策略层。高层策略的训练目标是最大化环境奖励 R。每 c 个时间步骤,高层策略都会采样一个新动作,这是低层策略所要达成的「目标状态」。低层策略的训练目标是选取合适的环境动作,使其能产生类似于给定目标状态的状态观察。

举一个简单的例子:假设我们在训练一个机器人以特定的顺序堆叠彩色方块。我们仅有单个奖励 1 在任务成功最终完成时给出,所有其它时间步骤的奖励都是 0。直观地说,高层策略负责提出所要完成的必要子目标:也许它输出的第一个目标状态是「观察到一个红色方块在你面前」,第二个目标状态可能是「观察到蓝色方块在红色方块旁边」,然后是「观察到蓝色方块在红色方块上面」。低层策略在环境中探索,直到其找到用于产生这些观察结果所必需的动作序列,比如选取一个蓝色方块并将其移动到红色方块之上。

HIRO 使用了 DDPG(深度确定性策略梯度)训练目标的一种变体来训练低层策略,其内在奖励被参数化为了当前观察与目标观察之间的距离:

DDPG 是又一种影响深远的深度强化学习算法,其将 DQN 的思想扩展到的连续动作空间。这也是一种 actor-critic 方法,使用策略梯度来优化策略;但不同于 A3C 中那样根据优势来优化策略,它是根据 Q 值来进行优化。因此在 HIRO 中,所要最小化的 DDPG 邻近误差就变成了:

同时,为了使用离策略的经历,高层策略使用了离策略修正来进行训练。其思想是:为了提升样本效率,我们希望使用某种形式的重放缓存,就像 DQN 一样。但是,过去的经历不能直接用于训练高层策略。这是因为低层策略会持续学习和改变,所以就算我们设置了与过去经历一样的目标,低层策略还是可能表现出不同的动作/转换。HIRO 中提出的离策略修正是为了回溯性地修改在离策略经历中看到的目标,从而最大化所观察到的动作序列的可能性。换句话说,如果重放经历表明过去的智能体采取动作 (x,y,z) 能达成目标 g,那么我们就寻找一个目标 g̃,使得它能让当前的智能体最有可能采取同样的动作 (x,y,z),即能够最大化该动作序列的对数概率(如下式)的动作。

然后使用 DDPG 的一种变体在这些动作、新目标和环境奖励 R 上训练高层策略。

HIRO 当然不是唯一一种 HRL 方法。FeUdal 网络是一种更早的相关研究(),其使用了一个学习到的「目标」表征而不是原始的状态观察。实际上,研究中的很多变体都源自学习有用的低层子策略的不同方法;很多论文都使用了辅助的或「代理的」奖励,还有一些其它研究实验了预训练或多任务训练。不同于 HIRO,这些方法中很多都需要某种程度的人工设计或领域知识,这从本质上限制了它们的通用性。近期也有研究在探索使用基于群体的训练(PBT,),这是另一个我个人很喜欢的算法。本质上讲,内部奖励被当作了附加超参数进行处理,通过在训练过程中「演进」群体,PBT 能学习到这些超参数的最优演化。

HRL 是当前一个非常受欢迎的研究领域,而且也非常容易与其它技术组合到一起,比如这篇论文将 HRL 与模仿学习结合了起来:。但是,HRL 的核心只是一个非常直观的思想。HRL 是可扩展的,具备神经解剖学上的相似性,能解决强化学习领域内的一些基本问题。但和其它优秀的强化学习方法一样,它的训练难度颇高。

记忆和注意

现在来谈谈用于解决长期信用分配和稀疏奖励信号问题的其它方法。具体而言,我们要说的是最明显的方法:让智能体真正擅长记忆事物。

深度学习中的记忆总是很有意思,因为不管研究者怎样努力(而且他们确实非常努力),很少有架构能胜过经过精心调节的 LSTM。但是,人类记忆的工作却与 LSTM 完全不同。当我们在处理日常生活中的任务时,我们会回忆和关注与场景相关的特定记忆,很少有其它内容。比如当我回家并开车到当地的杂货店时,我会使用我在这条道路上驾驶了数百次的记忆,而不是如何从 Camden Town 驱车到伦敦的 Piccadilly Circus 的记忆——即使这些记忆刚刚才加入我的经历,仍然活灵活现。就此而言,人类的记忆基本都是根据场景进行查询的——取决于我们在哪里以及做什么,我们的大脑知道哪些记忆对我们有用。

在深度学习中,这一观点催生了外部的基于关键值的记忆。这并不是一个新思想;神经图灵机(,这是我读过的第一篇而且是最喜欢的论文)使用了一种可微分的外部记忆存储来增强神经网络,可以通过指向特定位置的向量值的「读」和「写」头来访问。我们可以很容易想到将其扩展到强化学习领域——在任意给定时间步骤,智能体都会获得其环境观察和与当前状态相关的记忆。这就是近期的 MERLIN 架构的所做的事情:。

MERLIN 有两个组件:一个基于记忆的预测器(MBP)和一个策略网络。MBP 负责将观察压缩成有用的低维「状态变量」,从而将其直接存储到键值记忆矩阵中。它也会负责将相关的记忆传递给策略网络,然后策略网络会使用这些记忆和当前状态来输出动作。

这个架构可能看起来有些复杂,但要记住,其策略网络只是一个输出动作的循环网络,而 MBP 也仅做三件事:

将观察压缩成有用的状态变量 z_t,从而传递给策略。

将 z_t 写入记忆矩阵

获取其它有用的记忆并传递给策略

其工作流程看起来是这样的:输入的观察首先被编码并被输入一个 MLP,这个 MLP 的输出会被添加到下一个状态变量的先验分布上,从而得到后验分布。这个后验分布基于所有之前的动作/观察以及新的观察,然后会被采样以产生一个状态变量 z_t。接下来,z_t 会被输入 MBP 的 LSTM,其输出会被用于更新先验分布以及通过向量值的「读取键」和「写入键」来对记忆进行读取/写入——这两者是以作为 LSTM 的隐藏状态的线性函数得到的。最后,下游的工作是策略网络使用 z_t 以及从记忆读取的输出来得出一个动作。

其中一个关键细节是:为了确保状态表征有用,MBP 也经过了训练以预测当前状态 z_t 的奖励,这样所学习到的表征就与当前任务存在关联。

MERLIN 的训练有一些复杂;因为 MBP 的目标是用作一种有用的「世界模型」,这是一个难以实现的目标,所以它实际上的训练目标是优化变分下界(VLB)损失。(如果你不熟悉 VLB,可以参考这篇文章:-lower-bound/ ;但就算你不理解,也不妨碍你理解 MERLIN。)这个 VLB 损失包含两个成分:

在这下一个状态变量上的先验和后验概率分布之间的 KL 距离,其中后验分布还额外有新观察的条件。最小化这个 KL 距离能确保新状态变量与之前的观察/动作保持一致。

状态变量的重构损失;我们试图在这个状态变量中重现输入的观察(比如图像、之前的动作等)并基于该状态变量预测奖励。如果这个损失很小,说明我们就找到了一个能准确表征该观察的状态变量,而且它还可用于产生能得到高奖励的动作。

下式就是我们最终的 VLB 损失,其中第一项是重构损失,第二项是 KL 距离:

这个策略网络的损失是我们上文讨论过的 A3C 的策略梯度损失的稍微更好的版本;它使用的算法被称为「广义优势估计算法」,其细节超出了本文的覆盖范围(但能在 MERLIN 论文附录的 4.4 节找到),但其看起来就类似于下面给出的标准的策略梯度更新:

一旦训练完成,MERLIN 应该就能通过状态表征和记忆来预测性地建模世界,其策略也应该能够利用这些预测来选取有用的动作。

MERLIN 并不是唯一一个使用外部记忆存储的深度强化学习研究。早在 2016 年,就有研究者将这一思想用在了 MQN(记忆 Q 网络)中来解决 Minecraft 中的迷宫问题: ;但使用记忆作为世界的预测模型的概念具有一些独特的神经科学方面的推动力。有一篇 Medium 文章()很好地解释了这一思想,所以这里就不再重复了,只说说其关键论点:不同于对大多数神经网络的解释,我们的大脑很可能不是以「输入-输出」机器的运作的。相反,其工作类似与一个预测引擎,我们对世界的感知实际上只是大脑对于我们的感官输入的原因的最佳猜测。神经科学家 Amil Seth 对 Hermann von Helmholtz 在 19 世纪提出的这一理论进行了很好的总结:

大脑被锁在颅骨中。它所接受的都是模糊和有噪声的感官信号,这些信号仅与世界中的物体存在间接的关联。因此,感知必然是一个推理过程,其中非确定性的感官信号会与对世界的先前预期或「信念」结合起来,以构建大脑对这些感官信号的原因的最佳假设。

MERLIN 的基于记忆的预测器的目标正是实现这种预测推理。它会对观察进行编码,然后将它们与内在的先验结合起来,从而生成一个涵盖输入的某些表征(或原因)的「状态变量」,这些状态会被存储在长期记忆中以便智能体之后能基于它们采取行动。

智能体、世界模型和想象

有意思的是,大脑类似预测引擎的概念会将我们带回我们想要探究的第一个强化学习问题:如何从环境中有效地学习?如果我们不能直接根据观察得到动作,那么我们又该如何最好地与周遭环境交互并从中学习呢?

在强化学习领域,传统的做法要么是无模型学习,要么是基于模型的学习。无模型强化学习是学习直接将原始的环境观察映射到价值或动作。基于模型的强化学习则是首先学习一个基于原始观察的环境的过渡模型,然后使用该模型来选择动作。

图中外圈表示基于模型的强化学习,包含「direct RL」的内圈表示无模型强化学习。

比起无模型学习中单纯的试错方法,基于模型进行规划的样本效率要高得多。但是,学习优良的模型往往非常困难,因为模型不完美造成的误差往往会导致智能体表现糟糕。因为这个原因,深度强化学习领域内很多早期的成功研究(比如 DQN 和 A3C)都是无模型的。

话虽如此,1990 年的 Dyna 算法()就已经模糊了无模型和基于模型的强化学习方法之间的界线,其中使用了一个学习后的模型来生成模拟的经历,以帮助训练无模型策略。现在,已有研究将这两种方法直接组合到了一起,即「想象力增强的智能体」算法(I2A,)。

在 I2A 中,最终策略是一个与无模型组件和基于模型的组件相关的函数。基于模型的组件被称为该智能体对世界的「想象」,其由该智能体内部的学习后的模型所产生的想象轨迹组成。但是,其关键的地方在于基于模型的组件的末端还有一个编码器,它会将想象轨迹聚合到一起并解读它们,使得智能体能学习在有必要时忽略自己的想象。也就是说,如果智能体发现其内部模型投射的轨迹是无用的和不准确的,那么它就可以学会忽视该模型并使用其无模型分支进行处理。

上图展示了 I2A 的工作。观察一开始就会被传递给无模型组件和基于模型的组件。在基于模型的组件中,会根据在当前状态可能采取的 n 个动作来想象 n 个不同的轨迹。这些轨迹是通过将动作和状态输入其内部环境模型而得到的,从而能够过渡到新的想象状态,然后取其中能得到最大化结果的动作。一个蒸馏后的想象策略(与通过交叉熵损失的最终策略相似)选择下一个动作。经过固定的 k 个步骤之后,这些轨迹会被编码并被聚合到一起,然后会与无模型组件的输出一起输入策略网络。关键的地方在于,这种编码能让策略以最有用的解读想象轨迹——如果不合适就忽视它们,在可用时就提取出其中与奖励无关的信息。

I2A 的策略网络是通过一个使用优势的标准策略梯度损失训练的,类似于 A3C 和 MERLIN,所以这应该看起来很眼熟:

此外,在实际策略和内部模型的想象策略之间还添加了一个策略蒸馏损失,以确保想象策略选择的动作接近当前智能体会选择的动作:

I2A 的表现优于包含 MCTS(蒙特卡洛树搜索)规划算法在内的很多基准。即使在其基于模型的组件被故意设计得预测结果很差时,它也能在实验中得到出色的表现,这说明它能权衡所要使用的模型——在有必要时也会使用无模型方法。有意思的是,内部模型较差的 I2A 的表现实际上还稍微优于有较好模型的 I2A——研究者将其归因于随机初始化或有噪声的内部模型能提供某种形式的正则化,但很显然这还是一个有待进一步研究的领域。

不管怎样,I2A 都很出色,因为它在某些方面也体现了人类在世界中的运作。我们总是在根据对我们所处的环境的某个心智模型来规划和预测未来,但我们也都清楚我们的心智模型并不完全准确——尤其是当我们处在新环境中或遇到我们未曾见过的情形时。在这种情况下,我们会进行试错,就像是无模型方法一样,但我们也会使用新的经历来更新我们内在的心智模型。

目前有很多研究者都在探索如何有效结合基于模型的方法和无模型方法。Berkeley AI 提出了一种时间差分模型:;其也有一个非常有趣的前提。其思想是让智能体设置更多时间上抽象的目标,即「在 k 个时间步骤内处于 X 状态」,然后在保证最大化每 k 个步骤所收集到的奖励的同时学习这些长期的模型过渡。这能为我们提供对动作的无模型探索和在高层目标上的基于模型的规划之间的平滑过渡——如果思考一下这种方法,你会发现这又会将我们带回分层式强化学习。

所有这些研究论文都关注的是同样的目标:实现与无模型方法同样(或更优)的表现,同时达到基于模型的方法那样的样本效率。

总结

深度强化学习模型确实很难训练,这一点毫无疑问。但正是由于这样的难度,我们才提出了那么多的策略、方法和算法,以便能借助深度学习的强大力量来解决经典(或非经典)的控制问题。

这篇文章对深度强化学习的近期研究进行了不全面的介绍——还有大量研究没有提及,甚至还有很多研究我根本就不知道。但是,希望这里介绍的一些记忆、分层和想象方向的研究能够帮助读者了解我们着手解决强化学习领域内一些长期挑战和瓶颈的途径。

梦回过去是什么原因

为什么我们的记忆会出现偏差

第一种可能。

每个人的身命轨迹都经历过无数次,相同的人相同的事反反复复地做,这就是生命的轮回。

佛说我们做过的事情都存储在阿来耶识里面,当我们遇到与过去生中类似的事情或印象特别深刻的事情时,会自动调用一部分。

给我们的感觉就是——似曾相识。

第二种可能。

每个人都有预知未来的能力,只是被贪婪和遮挡。

当我们在某一刻心神宁静的时候,未来会自然显现。

第三种可能。

第六感,生命的自我保护。这也是每个生命自带的功能,只是没有开发而逐渐退化。偶尔会闪现一下,没有什么神奇的。

现在人崇尚科学,对生命的研究流于表面。尤其随着科技的开发,使生命的功能逐渐退化。

君如对生命感兴趣,闲暇时不妨读读圣贤典籍。里面对生命的本质,以及对开发生命自身功能等等,有非常详尽的描述。

注:君如读书,当以儒释道为主,旁门左道的书有害无益。

末学后进,才疏学浅,仅供参考。

深度沉浸式体验游戏距离我们还远吗

七麦数据为你解答!

这一次,屏幕前的用户不再是旁观者,而是可以主角共同执行任务的剧情参与者或者游戏参与者。【隐形守护者】上线 8 天以来在 iOS 应用、娱乐付费榜中持续霸榜,总榜也连续稳坐 Top1,iOS 下载量近 50w,作为一款付费 App 上线短短一周时间能有如此成绩不得不说用户对于互动剧/情景互动游戏认可与支持。

沉浸式情景交互 App 深受用户好评

【隐形守护者】是 2019 年 1 月 23 日上线游戏平台 Steam 的一款互动影响游戏,上线后 Steam 好评率长期保持在 90% 以上「特别好评」的区间,一个月后,就登顶 Steam 全球销量榜榜首。同时 B站游戏主播视频超过 1000 支、单支视频最高播放量超过 130 万次;知乎热搜榜上有名、豆瓣评分 9.7 分、TapTap 评分 9.8 分……自 5 月 3 日【隐形守护者】在苹果 App Store 上线后,其口碑和讨论一路攀升,这也让更多用户了解到,沉浸式情景交互的效果及影响力。

【隐形守护者】中,玩家扮演的主角肖途是一名地下党员,自 1939 年从日本回国后便被组织安插到日本驻沪领事武藤志雄身边,自此开始了在上海滩波云诡谲的潜伏生活。在这种国战背景验的尔虞我诈的无奈与,身边人的信任与背叛,让用户一开始就停不下来,所有的故事都取决于你会如何选择。

在【隐形守护者】微博超话#100个安利的理由#中,也有无数粉丝诉说着对这款互动游戏的热爱,也预示着沉浸式情景交互 App 时代的到来,以及未来“小说”、“影视”(电影、电视剧、网剧、动漫等)、“游戏”无界共存的可能性。

互动游戏or互动剧无需界定,用户是关键

其实类似这种沉浸式情景交互形式除了【隐形守护者】,还有同为极光游戏出品在 2 月 26 日上线的【记忆重构】,虽然结局只有一个,但解谜互动游戏 剧情搭建也让其在当时 iOS 总榜和游戏免费榜进入 Top5 的位置。

另外【腾讯视频】出品的《古董局中局之佛头起源》和【芒果TV】出品的《明星大侦探之头号嫌疑人》两部互动剧也为两款视频 App 引流不小,互动剧的尝试也逐渐打开了视频产品传统的社交模式(例如:弹幕、圈子等),让用户站在上帝视角体验不一样的用户交互。

相信对于沉浸式小说爱好者一定对橙光游戏相当熟知,作为小说情景交互的大佬,橙光游戏大部分的角色扮演、文字游戏等都是以交互形式展现的,利用小说情节引导用户作为主角选择,选择结果不同结局体验和展现也不同。

而对于关于如何界定或者判断一个产品究竟是游戏还是互动剧时,橙光也给出了己方意见:根据发行渠道来界定。在游戏的发行渠道发,那么就可以视为真人互动游戏,在视频网站上线,那么可以称其为互动剧。

但其实无论是影视、小说还是游戏对于用户来讲更多的是娱乐休闲,所以用户感觉有趣、吸引人、代入感强才是本身需要关注的,从这个角度来看,产品/作品的出发角度更应该是基于用户,而从用户出发的话,无所谓如何界定只要能够吸引用户,保持用户忠诚度并且促进其为产品买单就是成功。

情景互动给用户更多选择机会

虽然互动剧或沉浸式情景互动不是一个新鲜的词语,但是对于目前这种展现形式的产品并未成熟,也并不精致。很多时候产品并未了解交代清楚互动的前因后果,只是单纯的选择,没有伏笔、铺垫,就是一顿选,甚至很多为了选而选,如果是这样的体验的话对于用户来讲更会是即来即走的模式,想要留住用户,意犹未尽深入人心,才是正确利用的。

其实作为应用或游戏,已有不少开发者在形成个性化模式,打造“千人千面”的概念时,利用沉浸式情景互动模式提高用户对其产品的探索与依赖。就拿腾讯游戏与完美世界游戏共同打造的【完美世界】里面涉及的探索、气运是通过与人物对话选择的不同方向及分配的,对于每个人的选择不同出现的游戏人物所展示出来的气运也就不相同。

神谕是根据选择结果而改变述数值提升的

用户的选择改变剧情发展或内容重塑的这种体验,会让用户觉得自己和别人并不一样(这也是在打造个性化概念的一种),或拥有一个上帝视角在意图改变。就像【式家长】的火爆一样,越来越多的用户希望通过自己的行为改变人物,通过自己的阅历教导出心目中的“孩子”。

然而教导出来的“孩子”也许并不是想象的那样,或者和别人完全相反的产物。但这都体现了“千人千面”的概念,每个人不一样,选择不一样,得到的结果自然也就不一样。

其实从某种意义上来讲,平行时空的概念用在情景互动更恰当,产品架构了情景互动时,其实也是在虚拟空间中架构了平行时空。选择,决定了人生拐点,一个人不同的选择会展现出不同的人生,而情景互动则是站在上帝视角体验不同人生的一种交互,而这种交互让用户既期待又想尝试,因为这种选择没有对错,没有需要承担的严重后果,选择只是会导致得到与失去的东西会不同,仅此而已。

虽然这种用户交互形式并未成熟,还有很多地方需要不断改进,但是也正因为目前的不成熟,提供了很大成长空间,尚未普及的沉浸式情景交互模式也将迎来一片会有更多可能性的蓝海区域。

结语

沉浸式情景交互形式对于用户交互开拓了更深度的体验,无论是应用或是游戏在用户交互方面涉及时潜移默化的传递信息,用户自主选择的空间都可以提升对其探索和兴趣度,使用户留存或活跃有不错的体验。

跨界合作并不一定止步于品牌间的合作,也可以是行业间的合作,而界限无需分清,只需满足目标用户,提升其对产品的认可度或忠诚度即可。

大脑是如何提取记忆的

我将提问总结归纳为以下几个方面的问题:1.记忆的本质 2. 记忆的储存问题3. 记忆的提取问题。

- 记忆的本质

从神经生物学的角度来看,目前主流观点是“神经元学说”,认为记忆是在神经细胞间联结的动态变化中得到编码的,换句话来讲,记忆可以体现神经细胞之间联结的可变性和可塑性。可以看出来,记忆的形成不是哪一个神经元决定的,而 是有很多神经元相互连接,相互作用的。记忆按照记忆时程的长短分为瞬时记忆、短时记忆、长时记忆和永久记忆,目前认为各类记忆的脑内机制是不相同的,记忆的分类以及不同记忆类型的比较如图1~2所示:

当然,我也一直强调神经科学领域的发展和进展是非常迅猛的,很多观点和结论都在不断被完善和更新。我记得在2016年1月份的一次有关学习与记忆的论坛上,钟毅老师提出过“重复学习不改变记忆的形成,重复改变记忆的遗忘。”的观点,也就是说他认为每次学习过程中,第一次产生的是学习,后面的重复都是抑制遗忘。他用果蝇为模型,用行为学、细胞分子学等研究方法阐明了自己的观点,这个观点打破了短时程记忆转成长时程记忆大多需要consolidation(巩固)的过程的理论,当然,这也只是一种理论,而且模式动物用的是无脊椎动物果蝇,所以是否在灵长类动物和人类身上也适用也是不得而知。

深一步的从学习与记忆的分子机制来看,现在的研究认为,记忆源于突触的微小改变,这种变化在全脑都有体现。这样一来,记忆的物质基础的研究范围缩小到突触修饰上,于是科学家先从最简单的无脊椎动物神经系统入手探索记忆的分子机制。这里首先要提到的就是20世纪末,美国哥伦比大大学科学家Eric Kandel成功的建立了海兔(Aplysia)的学习和记忆行为模型,这一先驱性实验显示了记忆的储存位点和形成机制,从而系统的揭示了学习记忆可能的细胞和分子机制,也因此他获得了2000年诺贝尔奖。这个模型主要研究的是程序性记忆,包括海兔的非联合型学习和海兔的联合型学习,其中非联合型学习又包括“缩鳃反射的习惯化”和“缩鳃反射的敏感化”,而联合型学习也就是指经典的条件反射。这里简单介绍一下他们的细胞分子机制:

1)海兔的非联合型学习——缩鳃反射的习惯化

如果将水流喷射到海兔的虹管,虹管和鳃会收缩,称为缩鳃反射(图3)。Kandal实验的结论是:缩鳃反射的习惯化与突触前修饰有关,反复刺激感觉神经末梢会使神经递质的释放量减少。进一步来讲,钙离子通过电压门控钙离子通道进入神经末梢,但是当钙离子通道反复开放时,它的效能就会逐渐降低,钙离子内流减少,神经递质释放量减少(图4)。

2)海兔的非联合型学习——缩鳃反射的敏感化

短暂电极海兔的头部,结果导致再刺激虹管引起的强烈的缩鳃反应(图5)。由于点击海兔头部会引起L29释放五羟色胺(5-HT),随后激活感觉神经末梢G蛋白耦联的腺苷酸环化酶,随后导致cAMP产生,cAMP可以激活蛋白激酶A(PKA),PKA磷酸化钾离子通道蛋白,导致钾离子通道关闭,突触前动作电位延长,促进动作电位期间钙离子内流增多,神经递质释放量增多(图6)。

3)海兔的联合型学习

即非条件刺激是强电击海兔尾部,条件刺激是对虹管的轻微刺激,后来如果将尾部刺激和虹管刺激相结合后,单独刺激虹管后产生的反应要比敏感化引起的反应还要强。从分子水平上的解释是条件刺激表现为钙离子内流,非条件刺激表现为突触前神经末梢腺苷酸环化酶的G蛋白激活,当突触前钙离子冲动与G蛋白耦联受体激活导致cAMP大量生成在时间上恰好重合,或者钙离子冲动稍微较后者快一点时,产生学习,而记忆则在钾离子通道被磷酸化和神经递质释放增加时产生。(图7)

关于用脊椎动物模型来研究哺乳动物的突触可塑性的内容是非常的多,在这里我只提几个哺乳动物中学习和记忆的细胞分子学机制中非常重要的关键词:海马的长时程增强(long-term potentiation,LTP),突触传递的长时程压抑(long-term depression,LTD),NMDA受体(N-methyl-D-aspartate receptor)。总的来说,药理学和遗传学的研究都表明,海马NMDA受体在突触修饰作用(比如说LTD和LTP)和学习记忆中都有着很关键的作用。

2.记忆的储存

记忆的物质表现或位置可以叫做记忆的痕迹(memory trace),同时也不得不提到加拿大心理学家Donald Hebb,Hebb提出了细胞集合理论:脑内反映某外界客观物体,是由被该外界刺激激活的所有皮层细胞组成的,这些同时被激活的神经元称作“细胞集合”,假如这些细胞相互连接,细胞集合内的连接持续激活,对外界客观物体的内部反应就能作为短时程记忆始终保存,如果细胞集合能持续激活很长一段时间,那么细胞间相互连接更有效的神经元就会连接在一起,更紧密的连接就会使细胞集合再次兴奋,记忆的巩固就可能发生(图8)。简单的讲,他的重要结论包括:

1) 仅仅集团内的一部分细胞的破坏并不能消除记忆,记忆的痕迹广泛分布于细胞集合的细胞连接内;

2)记忆痕迹可能包括了有关感觉和知觉的神经元。

不管怎么样,目前认为学习和记忆的功能不局限于大脑某一个单一的部位,而研究表明,陈述性记忆主要依赖于海马和相关结构,程序性记忆与纹状体相关,而工作记忆的痕迹是广泛分布于大脑内的,另外,长时程记忆被一些人认为是通过新皮层结构的变化来储存的记忆。所以说为了保障我们更好的生存下去我们,我的大脑是一直在不停的再重构的。

还有说法是,多数记忆材料都需要经过Joseph LeDoux提到的“短时缓冲装置”,即位于双侧听觉区、视觉区和运动知觉区的暂时存储区域后,然后才能进入工作记忆(一种暂时记忆,比短时记忆要长一些)和之后的长时记忆。而语义记忆、情景记忆、程序记忆、自动记忆和情绪记忆的通路则用于储存和提取长时记忆的信息。其中,情景记忆和语义记忆(两者都属于陈述性记忆)主要储存在海马;程序记忆和自动记忆主要储存在小脑;情绪记忆主要储存在杏仁核。这里再简单解释一下这五种记忆:

- 语义记忆:人们对一般知识和规律的记忆,比如你阅读文献所得到到知识的记忆。

- 情景记忆:可以理解成关系记忆或者空间记忆,主要是指位置信息。

- 程序记忆:通常也成为“肌肉记忆”,比如我们学开车、骑自行车等记忆。

- 自动记忆:也称作为conditioned response memory,表现为特点的刺激对记忆的自动激发,例如说你唱着歌我自动的就接下一句的这种状态。

- 情绪记忆:就是关于情绪的记忆,值得一提的是,情绪记忆总是优先于其他任何一种记忆。

举个例子来说明这个过程:你在看一篇文献(产生了是语义记忆),新的知识信息通过传送到海马后,海马把信息带到暂时存储区域,如果这些新信息与之前传入的信息是有关联的,那么它会被传到前额叶皮层的工作记忆,工作记忆进一步可以进行信息的分类整理,如果再加上先前对文献所述的相关内容的作用,这些新旧信息可以联系起来,这个过程重复多次后,就有可能形成长时记忆。

3. 记忆的提取问题

刚才有提到语义记忆、情景记忆、程序记忆、自动记忆和情绪记忆这5条记忆通路,一种说法是,我们很多时候会通过这些记忆通路来激活记忆,开启回忆。具体的举个例子来讲,寒假回家爸爸接我回家,车里放着CD,当放到《同桌的你》时,我都会不自主的跟着哼(歌曲开启了自动记忆),然后当车经过我初中学校的时候,都会勾起我对美好童年的回忆(通过初中学校这个地点,情景记忆通路被激活),然后我想起每天放学和同学迫不及待开心的蹲在学校门口看商贩贩卖小鸡小鸭子和蚕的场景,觉得小时候的我好天真可爱,“噗嗤”一下笑了出来,于是心情大好,突然想下车看看学校门口有什么新变化(情景记忆通路激活了情绪记忆,同时由于情绪记忆总是优先于其他记忆的,当情绪记忆主导时,人很容易失去逻辑能力,做出背离理智的决定),我于是来到校门口,发现校门口开了家新的炸鸡店,名字叫“来自星星的炸鸡”,我买了一份尝了后觉得很好吃,突然想起其闺蜜说过她很喜欢吃炸鸡(语义记忆通路被打开),于是我告诉她校门口新开了一家好吃的炸鸡店,明天约她一起吃炸鸡。

总结:

神经科学是一个非常值得探索的领域,我们的大脑大约有1000亿个神经元,但是他们到底是如何工作的,依然是个迷。两年前欧美很多国家纷纷启动了脑科学计划,而在2015年10月,科学院神经科学研究所所长蒲慕明报告中介绍China Brain Project也将启动,各个领域的科学家也都积极响应,可见这个领域的热门程度。

目前就我们的了解,记忆能是发生在突触处的,而且各类动物的学习和记忆在细胞和分子机制上都是很相通的。典型的事件是:脑中电活动的改变,然后第二分子的变化(如cAMP,钙离子),之后是突触蛋白的修饰,这些暂时的变化通过改变突触结构从而成为永久变化,形成长时程记忆。随着神经科学的迅速发展,我相信会有更多更新颖,合理和突破性的理论产生,说不定哪天真发明出让人过目不忘的“记忆面包”呢!

私信我:记忆,领取记忆法系统课程

小编推荐阅读

电工手游网发布此文仅为传递信息,不代表电工手游网认同期限观点或证实其描述,如有侵犯您的隐私请联系我们。